Directrice de recherche au centre Inria (Saclay), Wendy Mackay dirige le groupe de recherche en interaction humain-machine (IHM) Ex-Situ, commun avec le Laboratoire de recherche en informatique (LRI – université Paris-Saclay, CNRS). Reconnue internationalement dans cette discipline, la chercheuse est membre de l’ACM SIGCHI Academy (Association for Computing Machinery – Special Interest Group on Computer-Human Interaction).

Elle est invitée pour l’année 2021-2022 sur la chaire Informatique et sciences numériques, chaire créée en partenariat avec Inria.

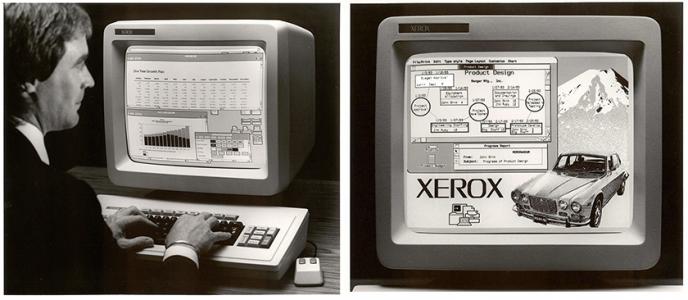

L’étude de l’interaction entre l’humain et la machine est cruciale à l’heure où la technologie est omniprésente. Sur quoi doit-elle se fonder ?

Wendy Mackay : C’est intéressant d’étudier la machine d’une part et l’humain de l’autre, mais insuffisant. Ce que nous faisons dans notre domaine, c’est essayer de comprendre comment ces deux parties interagissent. En tant qu’êtres humains, nous sommes indéniablement influencés par les technologies que nous utilisons quotidiennement ; celles-ci peuvent affecter nos comportements et changer notre manière de réfléchir, mais nous pouvons aussi les adapter à nos besoins en nous les appropriant. Il faut bien comprendre que toutes les capacités humaines sont parties prenantes de l’équation qu’est l’interaction humain-machine. Cela implique de prendre en compte des notions comme la sensation, la perception, l’aspect moteur, la mémoire… toute la psychologie humaine, en somme. Par exemple, l’un de nos sujets de recherche consiste à observer le phénomène de deskilling, c’est-à-dire le processus par lequel les compétences d’un humain sont rendues désuètes, voire perdues, lorsqu’un élément de technologie peut accomplir la tâche pour lui. On observe depuis longtemps cette diminution des capacités humaines relative à la délégation aux machines. Toutefois, on pourrait aller dans le sens inverse et chercher un moyen d’améliorer les compétences et capacités humaines par le biais de cette interaction.

Comment pourrait-on repenser cette interaction pour stimuler les capacités de l’utilisateur ?

Nous considérons plusieurs stratégies pour y parvenir. Ce qui est très plaisant, aujourd’hui, c’est que certains chercheurs du domaine de l’intelligence artificielle commencent à travailler avec nous, spécialistes de l’interaction humain-machine. Prenons l’exemple d’une décision qu’un utilisateur doit prendre à l’aide d’un logiciel ou d’une machine. S’il dispose d’un système qui lui dit directement « il faut choisir A et non B », et que l’utilisateur sait que ce système a généralement raison, il va simplement se contenter de faire ce que lui dit la machine sans recourir à sa propre réflexion : ses capacités n’étant plus stimulées, elles risquent de s’affaiblir.

Si nous concevons un système qui, au lieu de donner directement la réponse, doit plutôt réagir à une proposition de l’utilisateur, alors nous créons une situation qui stimule davantage les compétences humaines par la réflexion et l’interaction. C’est un moyen d’apprentissage, ni plus ni moins, entre intelligence artificielle et intelligence humaine. Cependant, des interactions différentes peuvent engendrer une grande variété d’effets, à long terme, sur un utilisateur. Donc, c’est assez compliqué à mettre en place.